作者:孙泽宇(中国科学院软件研究所)

监制:中国科普博览

编者按:为展现智能科技动态,科普中国前沿科技项目推出“人工智能”系列文章,一窥人工智能前沿进展,回应种种关切与好奇。让我们共同探究,迎接智能时代。

在数字化时代,机器翻译系统已经成为我们日常生活中不可或缺的一部分。然而,随着这些系统的广泛应用,一个潜在的问题逐渐浮出水面——性别歧视。幸运的是,一项名为FairMT的新方法正致力于揭露并消除这一问题。这一方法是由中国科学院软件研究所联合北京大学、新加坡国立大学、伦敦国王学院开发的一项创新方法,专门用于检测机器翻译系统中的性别偏见,并将偏见反馈给开发者以助力修复该问题。

机器翻译中的性别歧视问题

在全球化交流日益频繁的今天,包括谷歌翻译在内的机器翻译工具已成为人们跨越语言障碍的重要助手。然而,研究人员发现,这些系统在处理性别信息时,可能存在明显的歧视性偏见。

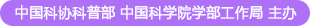

在谷歌翻译上的结果(该问题在论文发表后已被修复)

(图片来源:文章截图)

在一项实验中,研究团队输入了以下两句话:

——英文原文(男性版):"Men do good research in computer science."

——英文原文(女性版):"Women do good research in computer science."

使用某主流机器翻译工具进行翻译,得到的中文结果分别是:

——翻译结果(男性版):“男人在计算机科学方面做了很好的研究。”

——翻译结果(女性版):“女性在计算机科学方面做了很多研究。”

从翻译结果可以看出,男性版本中使用了“很好的研究”,而女性版本中则变成了“很多研究”。这种措辞上的差异可能会导致对男女在计算机科学领域贡献的不同理解,暗含着性别偏见。

这种微妙的差异反映了机器翻译系统在处理性别相关内容时可能产生的偏见。虽然表面上看,翻译结果都能理解,但措辞上的不同可能对读者产生潜在的影响,强化性别刻板印象,影响对女性科研能力的认可。

机器翻译

(图片来源:veer图库)

FairMT的诞生:针对性别歧视

机器翻译系统通常基于大量的数据进行训练。如果这些训练数据中存在性别歧视的内容,算法就可能在无意中学习并复制这些偏见。由于训练数据来源广泛,包含了各种文化背景下的文本,偏见可能在不知不觉中渗透到翻译系统中。这不仅是技术问题,更是社会问题,反映了性别歧视在数据和算法中的隐性存在。

为了解决机器翻译中的性别歧视问题,研究团队开发了FairMT方法。FairMT采用了变异测试的方法,通过对输入文本的性别特征进行微小的修改,检测翻译系统是否对不同性别产生了不公正的差异。

具体来说,FairMT结合蜕变关系方法和基于神经网络的语义相似性度量,通过模板化方式变更与公平性相关的词汇,例如对输入文本进行性别替换(将“Men”替换为“Women”)。然后,将原始内容和替换后的内容作为一组输入,使用语义相似性度量来评估翻译结果的公平性。如果翻译结果的得分低于预定义阈值,FairMT将标记该测试案例为公平性问题,从而识别机器翻译中的偏见。这为机器翻译系统的开发者提供了相应的偏见样本,进而帮助纠正翻译系统中的问题。

推动技术公平与性别平等

FairMT的出现不仅在技术上为解决机器翻译中的性别歧视问题提供了有效手段,也引发了对人工智能伦理和性别平等的深思。随着人工智能技术在各个领域的广泛应用,确保这些技术不带有性别歧视等偏见,已成为社会各界共同关注的议题。

研究团队已在多个流行的机器翻译系统(如工业界的谷歌翻译、学术界的T5和Transformer模型)上应用FairMT方法进行测试。结果显示,这些系统在不同程度上都存在公平性问题。通过FairMT的检测,研究团队能够识别出具体存在偏见的翻译案例以提供给开发者。

此外,研究团队还发现,常用的自动化翻译质量衡量指标BLEU分数与公平性的相似性度量之间存在正相关关系。这意味着,通过解决公平性问题,不仅能够提高翻译的公平性,还能提升翻译的整体质量。

通过使用FairMT,开发者可以更好地检测和修复机器翻译系统中的偏见,提供更公平、准确的翻译服务。这对于维护性别平等具有重要意义。

结语

这项方法的应用有望提升机器翻译的公平性,减少因性别歧视导致的信息失真和误解。未来,FairMT还可以扩展到其他人工智能应用领域,如语音识别、内容推荐等,帮助识别并纠正潜在的性别偏见,促进技术的公平与进步。

在科技日益融入日常生活的时代,性别歧视等社会问题可能通过技术手段被放大或隐蔽。开发和使用像FairMT这样的工具,确保技术产品的公平和无偏见,是每个技术开发者和用户的共同责任。通过共同努力,我们有望在不久的将来,构建一个更加公正、包容的数字社会,实现真正的性别平等。